时间:2025-07-02

在过去十年中,人工智能经历了从基础算法到复杂系统的飞速发展。近年来,随着AI大模型的兴起,业界开始重新思考传统人工智能技术架构的可行性与延展性。这些拥有数十亿甚至数千亿参数的大模型,正在以前所未有的方式推动着AI的发展边界。那么,AI大模型是否真的正在重塑人工智能的技术架构?这一问题值得我们深入探讨。

首先需要理解什么是AI大模型。这类模型通常指具有极大参数量的深度学习模型,如GPT、BERT、PaLM等。它们通过大规模数据集进行预训练,从而获得强大的泛化能力和迁移学习能力。“先训练后微调”的范式已经成为自然语言处理(NLP)、计算机视觉(CV)等多个领域的主流方法。

从技术架构角度看,传统AI系统往往采用模块化设计,不同功能由独立子系统完成。例如语音识别任务可能包括信号处理模块、特征提取模块、语言模型和解码器等。而AI大模型的出现正在改变这种结构。如今越来越多任务可以通过统一的大模型完成,无需复杂模块划分。这种端到端的学习方式不仅简化了系统设计,还提升了整体性能。

同时,AI大模型的计算需求对现有技术架构提出了新挑战。传统AI系统依赖专用硬件或轻量级模型实现高效推理,而大模型则需要更强大算力支持。这推动了云计算、边缘计算及异构计算平台的发展。GPU集群、TPU芯片和分布式训练框架成为支撑大模型运行的重要基础设施。这种转变意味着未来AI架构将更加依赖高性能计算资源,并促使整个产业向“云+AI”方向演进。

此外,AI大模型的可解释性和可控性也成为技术架构重构中的重要议题。由于内部结构极其复杂,传统调试与优化手段难以奏效。研究人员正在探索新的工具和方法,如模型蒸馏、可视化分析、因果推理等,以提升透明度和可控制性。这种趋势表明,未来的AI架构不仅要追求性能,还要兼顾安全、可信与伦理要求。

AI大模型还在推动软件栈的升级。从底层训练框架(如TensorFlow、PyTorch)到上层应用接口(如Hugging Face Transformers),整个生态都在围绕大模型进行优化和适配。自动化的超参数调优、高效的模型压缩技术、分布式的训练策略等都成为当前研究热点。这意味着,未来的人工智能系统将建立在一个更为成熟和完善的软件基础设施之上。

不仅如此,AI大模型还在促进跨模态融合的发展。过去图像、语音、文本等不同模态的数据往往由各自独立的模型处理。而现在,像CLIP、Flamingo、BEiT-3等多模态大模型已经能够同时理解和生成多种类型的信息。这种能力不仅提升了模型的表现力,也为构建更加通用的人工智能系统奠定了基础。

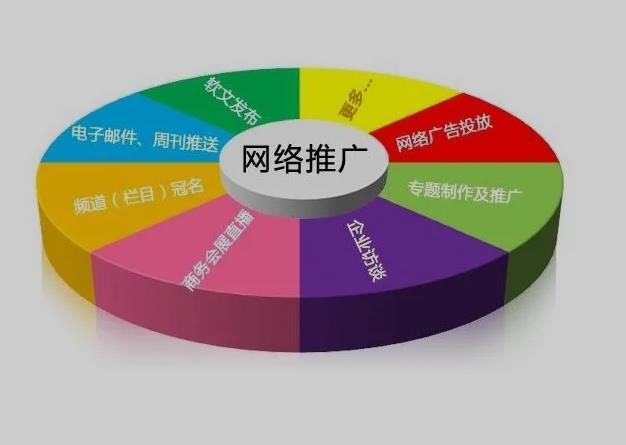

AI大模型带来的不仅是技术进步,还有商业模式创新。越来越多企业开始采用“模型即服务”(MaaS)的方式,将训练好的大模型作为API提供给开发者使用。这种方式降低了AI应用门槛,加速了技术普及,同时也催生了数据标注、模型定制、性能评估等细分市场。

当然,我们也必须清醒地认识到,AI大模型并非万能钥匙。虽然在某些领域表现出色,但也存在能耗高、部署难、数据依赖性强等问题。因此,在实际应用中,如何在大模型与小模型之间找到平衡,如何构建更加灵活和可持续的技术架构,依然是摆在面前的重要课题。

综上所述,AI大模型正在以前所未有的速度和广度影响着人工智能的技术架构。从模型结构、计算资源、软件生态到应用模式,每一个层面都在经历深刻变革。尽管仍有许多挑战有待解决,但可以预见的是,AI大模型将成为推动下一代人工智能发展的核心动力之一。